Webinar Internet governance e hate speechRete contro l'odio

Posted by Rete contro l'odio

Nel video: Quale equilibrio tra norme e libertà di espressione in rete? Come coniugare Internet governance, diritto di parola e contrasto ai discorsi d’odio? Per il ciclo di webinar “Dialoghi in Rete”, discutiamo di “Internet governance e hate speech”. Il webinar si è svolto il 5 maggio 2021 ed è stato realizzato con il contributo dell’Unione Cristiana Evangelica Battista d’Italia. Sono intervenuti: Debora Barletta, di No Hate Speech Movement Italia e Youth IGF – Internet Governance Forum; Nannerel Fiano, di VOX Diritti e ricercatrice di Diritto costituzionale presso l’Università degli Studi di Milano; Federico Faloppa, professore associato di Linguistica all’Università di Reading (UK) e Coordinatore della Rete nazionale per il contrasto ai discorsi e ai fenomeni d’odio; Giacomo Mazzone, membro del Comitato di Programma Internet Governance Forum Italia e Giovanni Ziccardi, professore di Informatica giuridica presso l’Università degli studi di Milano.

a cura del gruppo Advocacy della Rete

Internet governance, una breve definizione

Con l’espressione Internet Governance si intendono generalmente tutte le iniziative che determinano l’evoluzione e la gestione di Internet nei suoi vari aspetti tecnici, giuridici, economici, sociali e politici.

Tali iniziative – a cui prendono parte governi, settore privato, e società civile, nei loro rispettivi ruoli – si concretizzano nello sviluppo e nell’applicazione di principi, norme, regole, procedure decisionali e programmi condivisi.

In questo contesto, è importante notare che con governance non si intende ‘governo’ (di Internet). Le iniziative a cui si fa riferimento non sono infatti prerogativa dei governi nazionali – né sono associabili a una gestione centrale, ad un processo esclusivamente dall’alto verso il basso – ma rimandano a tutte le azioni condivise globalmente che devono essere compiute sulla Rete affinché

essa possa continuare a funzionare e a svilupparsi a beneficio di tutti i suoi utenti.

In italiano, quindi, governance si dovrebbe tradurre con ‘gestione’. Questa ‘gestione’ dovrebbe garantire integrazione globale, libertà di mercato ed equa concorrenza, difesa dei diritti delle persone, e in generale opportunità culturali, economiche, sociali per tutte le persone.

A questo scopo, sin dagli anni Ottanta si sono progressivamente sviluppate iniziative globali di vario genere: di standardizzazione tecnica (IETF), di gestione delle policy sulle risorse (ICANN), di discussione generale sul futuro della rete (IGF).

Un approccio globale: l’Internet Governance Forum (IGF)

L’istituzione dell’Internet Governance Forum (IGF) da parte delle Nazioni Unite nel 2005 ha reso possibile un modello, ancora oggi condiviso, di «multi-stakeholder», per garantire lo sviluppo della rete, delle tecnologie, dei servizi e dei mercati ad essa collegati tramite la collaborazione di diversi stakeholder, normalmente raggruppati in alcune «constituency»:

- governi e enti pubblici;

- settore privato;

- società civile;

- organizzazioni internazionali;

- accademia e comunità tecnica;

- utenti.

All’interno dell’IGF, questi stakeholders devono confrontarsi su alcune macro-aree:

- infrastrutture: infrastrutture di telecomunicazione, Internet service providers, Protocolli di controllo di trasmissione e protocolli internet, DNS (Domain Name Systems), Root zone e Root Servers, neutralità della Rete, standard tecnici e del web, servizi di Cloud, ecc.

- sicurezza: cybersecurity, cybercrime, infrastrutture critiche, cyber terrorismo, cyber conflitti e guerra informatica, crittografia, spam, firma digitale, sicurezza dei minori online, ecc.

- legalità: strumenti legali, giurisdizioni, risoluzioni alternative di dispute, diritto di proprietà intellettuale, copyright, marchi registrati, patenti e brevetti, leggi del lavoro, intermediari, ecc.

- commercio: E-commerce, Internet Data Economy, Internet Access Economy, trend emergenti: Internet of things, Intelligenza Artificiale, sharing economy, E-banking, E-money e valute virtuali, protezione dei consumatori, tasse, ecc.

- sviluppo: tecnologie digitali e sviluppo delle società, digital divide, sviluppo di competenze e capacità.

- socioculturale: policy dei contenuti, educazione online, diversità culturale, multilinguismo, beni pubblici, ecc.

- diritti umani: diritti umani online e offline, privacy e protezione dei dati personali, diritti dei minori online, diritti delle persone con disabilità, diritti di genere online.

Su queste macro-aree, l’IGF – pur sprovvisto di potere decisionale o vincolante – ha il mandato di:

- discutere di questioni di policy pubblica in relazione agli elementi chiave dell’Internet governance, per promuovere sostenibilità, sicurezza, stabilità e sviluppo di Internet;

- facilitare la discussione tra enti che si occupano di differenti politiche pubbliche internazionali che riguardano la gestione di internet;

- interfacciarsi con le organizzazioni inter-governative;

- facilitare lo scambio di informazione e buone pratiche, e massimizzare l’expertise delle comunità tecniche, scientifiche e accademiche;

- chiedere a tutti gli stakeholder di promuovere modi e strumenti per accelerare la disponibilità e l’accessibilità di internet nei paesi cosiddetti «in via di sviluppo»;

- rafforzare e migliorare l’impegno degli stakeholders nei meccanismi esistenti e/o futuri dell’Internet Governance;

- identificare problemi emergenti, portarli all’attenzione degli enti rilevanti e del pubblico in generale e, laddove appropriato, produrre specifiche raccomandazioni;

- contribuire allo sviluppo di competenze per l’Internet Governance in paesi in via di sviluppo, utilizzando al meglio risorse e competenze locali;

- promuovere e monitorare regolarmente l’applicazione dei principi del WSIS (World Summit on Information Society) sui processi dell’Internet Governance;

- discutere inter alia delle questioni legate alle risorse critiche di Internet;

- aiutare nella ricerca di soluzioni a questioni emergenti dal cattivo uso di Internet, in particolare in relazione a ciò che può danneggiare l’utenza comune.

L’impegno istituzionale in Italia sull’Internet Governance: breve cronologia

L’Internet Governance Forum ha, dal 2008, una sua presenza anche in Italia. Nel 2008 viene infatti affidato a Stefano Rodotà il coordinamento del Comitato di programma di IGF Italia, con lo scopo di dar vita a un tavolo di confronto con gli stakeholders di rete presenti nella Penisola.

L’interesse del Governo italiano per i temi dell’Internet Governance nasce però almeno un decennio prima, con la partecipazione ai progetti Pilota per la Società dell’Informazione lanciati dal governo del Canada, in occasione del Summit G7 del 1995, durante la XIII Legislatura. E si rafforza:

- con il DPCM del 5 febbraio 1999, che evidenzia quanto il governo ritenga «lo sviluppo della Società dell’Informazione un obiettivo fondamentale della propria azione»;

- con la costituzione del Forum per la Società dell’Informazione, che si concentra sui temi dell’infrastruttura di Rete, dell’alfabetizzazione informatica, dei servizi multimediali, della digitalizzazione della Pubblica amministrazione;

- con la creazione del COESIN, un Comitato di esperti di Internet che ha il compito di definire le linee strategiche di indirizzo per un approccio globale e sistematico delle problematiche inerenti la Rete.

Durante la XIV legislatura, sui temi dell’Internet Governance viene avviato inoltre un tavolo interministeriale tra il Ministero delle comunicazioni e il Ministero con delega all’Innovazione, mentre nel 2004 viene istituito il Tavolo di consultazione con la Società Civile sulle tematiche del World Summit on the Information Society (WSIS), e quindi, nel 2006, inizia a operare il Comitato Consultivo sulla Governance di Internet istituito dal Ministro per le riforme e l’innovazione nella Pubblica Amministrazione.

Nel 2008, come già ricordato, nasce l’IGF Italia. Nel 2014 nasce invece l’Intergruppo innovazione di Camera e Senato come libera associazione di parlamentari, appartenenti a tutti i gruppi politici, con l’obiettivo quello di promuovere l’innovazione tecnologica in Parlamento e nel Paese.

Nello stesso anno, la Presidente della Camera Laura Boldrini promuove anche la costituzione di una Commissione sui diritti e doveri in Internet presieduta dal sempre da Stefano Rodotà.

Il 28 luglio 2015, questa commissione approva la Dichiarazione dei diritti in Internet, che individua una serie di principi generali che abbracciano le diverse tematiche connesse all’uso della rete. Al «governo della rete» è dedicato l’Art. 14:

- Ogni persona ha diritto di vedere riconosciuti i propri diritti in Rete sia a livello nazionale che internazionale.

- Internet richiede regole conformi alla sua dimensione universale e sovranazionale, volte alla piena attuazione dei principi e diritti prima indicati, per garantire il suo carattere aperto e democratico, impedire ogni forma di discriminazione e evitare che la sua disciplina dipenda dal potere esercitato da soggetti dotati di maggiore forza economica.

- Le regole riguardanti la Rete devono tenere conto dei diversi livelli territoriali (sovranazionale, nazionale, regionale), delle opportunità offerte da forme di autoregolamentazione conformi ai principi indicati, della necessità di salvaguardare la capacità di innovazione anche attraverso la concorrenza, della molteplicità di soggetti che operano in Rete, promuovendone il coinvolgimento in forme che garantiscano la partecipazione diffusa di tutti gli interessati. Le istituzioni pubbliche adottano strumenti adeguati per garantire questa forma di partecipazione.

- In ogni caso, l’innovazione normativa in materia di Internet è sottoposta a valutazione di impatto sull’ecosistema digitale.

- La gestione della Rete deve assicurare il rispetto del principio di trasparenza, la responsabilità delle decisioni, l’accessibilità alle informazioni pubbliche, la rappresentanza dei soggetti interessati.

- L’accesso e il riutilizzo dei dati generati e detenuti dal settore pubblico debbono essere garantiti.

- La costituzione di autorità nazionali e sovranazionali è indispensabile per garantire effettivamente il rispetto dei criteri indicati, anche attraverso una valutazione di conformità delle nuove norme ai principi di questa Dichiarazione.

Il 3 Novembre 2015, la Camera approva il testo della Dichiarazione, che impegna il Governo a promuovere la costituzione della comunità italiana per la governance della rete definendo compiti e obiettivi in una logica multi stakeholder.

Internet Governance e diritto

Sul piano strettamente giuridico, parlare di Internet governance significa innanzitutto interrogarsi sul ruolo:

- di soggetti pubblici e privati nella gestione/governance di internet;

- del diritto e delle fonti normative nel regolamentare la rete e le responsabilità dei soggetti che la governano, nonché nel garantire i diritti degli utenti.

Riguardo al ruolo dei soggetti pubblici (statali), esistono due visioni alternative:

- Gli Stati non possono vantare alcun potere su internet, che deve essere considerato un’entità autonoma e indipendente (teorie cyber-anarchiche)

- Gli Stati possono esercitare i propri poteri anche nello spazio digitale, tenendo in considerazione la struttura della rete (Lawrence Lessig)

Per soggetti privati si intendono generalmente:

- Soggetti che garantiscono l’accesso alla rete (internet service provider)

- Soggetti che propongono contenuti, servizi, prodotti in rete (piattaforme, motori di ricerca e social networks)

Altri soggetti coinvolti, come sappiano, possono essere anche:

- la Società civile, la quale, sempre più, è in grado di influenzare l’internet governance, ad esempio per quanto al monitoraggio e al contrasto alla diffusione di contenuti illeciti. Il ruolo della società civile è valorizzato nei più recenti atti e proposte europee (cfr. Digital service act)

- gli utenti: il diritto si preoccupa di definire diritti e doveri degli utenti

In questo quadro, le responsabilità dei vari soggetti sono state fin qui disciplinate da normative sovranazionali e nazionali.

Nell’Ordinamento dell’Unione Europea, la fonte giuridica vincolante è la Direttiva 2000/31/CE (Direttiva e-commerce), la quale distingue tra tre tipologie di provider:

- Servizi di semplice trasporto “mere conduit” (art. 12)

- Memorizzazione temporanea detta “caching” (art. 13)

- Servizi di hosting (art. 14)

Seppur con alcune differenze relative alle tre tipologie, questa direttiva sancisce:

- l’esenzione da responsabilità dei provider poiché in via generale non controllano e non conoscono le informazioni trasmesse o memorizzate;

- in via eccezionale il provider è ritenuto responsabile se a) sia effettivamente al corrente del fatto che l’attività o l’informazione è illecita; b) non agisce immediatamente per rimuovere le informazioni o per disabilitarne l’accesso (art. 14)

- il divieto di imporre ai prestatori un obbligo generale di sorveglianza sui contenuti che trasmettono (art. 15)

Questa direttiva è stata recepita nell’ordinamento italiano con il Decreto legislativo n. 70 del 2003 sul commercio elettronico, il quale prevede un regime più protettivo per gli hosting provider per quanto riguarda la rimozione dei contenuti, prevedendo tale obbligo solo a seguito di comunicazione in tal senso delle autorità competenti (art. 16 e 17 D.lgs 70/2003).

Il decreto tuttavia non specifica quale autorità pubblica sia competente ad emettere l’ordine di rimozione, e presenta alcune criticità, ad esempio presentando a) l’idea che il provider sia un soggetto passivo e neutrale (mero intermediario), e b) un quadro di responsabilità non adeguato al contesto attuale, in cui i provider non sono soltanto meri fornitori di accesso, ma piattaforme che permettono lo scambio di contenuti e informazioni (social networks), servizi di cloud, commercio elettronico.

In ragione di questi cambiamenti, tanto la giurisprudenza sovranazionale (europea) quanto quella nazionale hanno in parte ridefinito i confini delle responsabilità dei fornitori di servizi, in particolare con:

- la sentenza della Corte europea dei Diritti dell’Uomo Ex multis C. Edu, Delfi AS c. Estonia(2015), che stabilisce che un portale di informazione è responsabile della violazione dell’art. 10 (libertà di espressione) della CEDU a causa della pubblicazione di commenti diffamatori;

- la sentenza Corte di giustizia dell’Unione Europea Ex multis CGUE, Google c. France (2010), dove si precisa che le esenzioni di responsabilità possono essere applicate solo se a) le attività del provider sono di ordine meramente tecnico, automatico e passivo; b) il provider non conosce e non controlla le informazioni memorizzate o trasmesse; c) il provider agisce come “un prestatore neutro”;

- le sentenze dei tribunali di Milano (9 novembre 2011) Torino (7 aprile 2017) e Roma (27 aprile 2016) che distinguono fra hosting passivo (provider neutro e imparziale), esente da responsabilità, e hosting attivo (provider gestore di contenuti), responsabile.

Importanti adeguamenti si potranno avere anche con l’approvazione del Digital service act, una proposta di regolamento presentata dalla Commissione europea nel dicembre 2020 che per la prima volta mira ad introdurre obblighi e regole comuni fra gli Stati membri riguardo al ruolo e alle responsabilità degli intermediari on line.

Il regolamento adegua infatti la disciplina delle responsabilità alle caratteristiche attuali degli intermediari e delle piattaforme, distinguendo tra servizi di intermediazione che offrono infrastrutture di rete (fornitori di accesso a Internet, registrar di nomi di dominio), servizi di hosting come cloud e webhosting; piattaforme online che riuniscono venditori e consumatori come mercati online, app store, piattaforme dell’economia collaborativa e piattaforme dei social media, piattaforme online di grandi dimensioni (quelle che raggiungono più del 10% dei 450 milioni di consumatori europei), le quali comportano rischi particolari per la diffusione di contenuti illegali e nocivi.

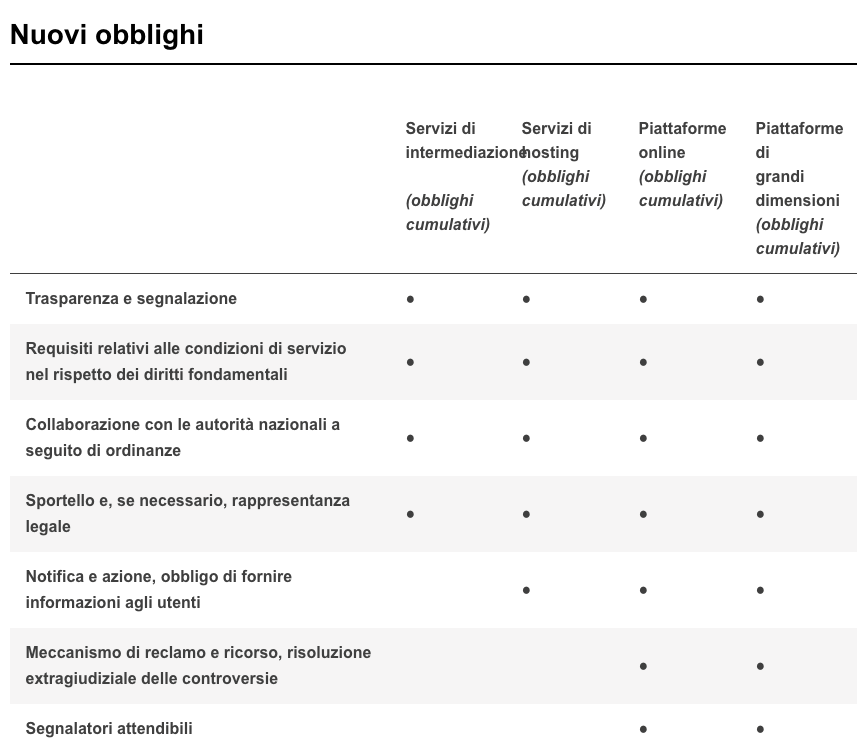

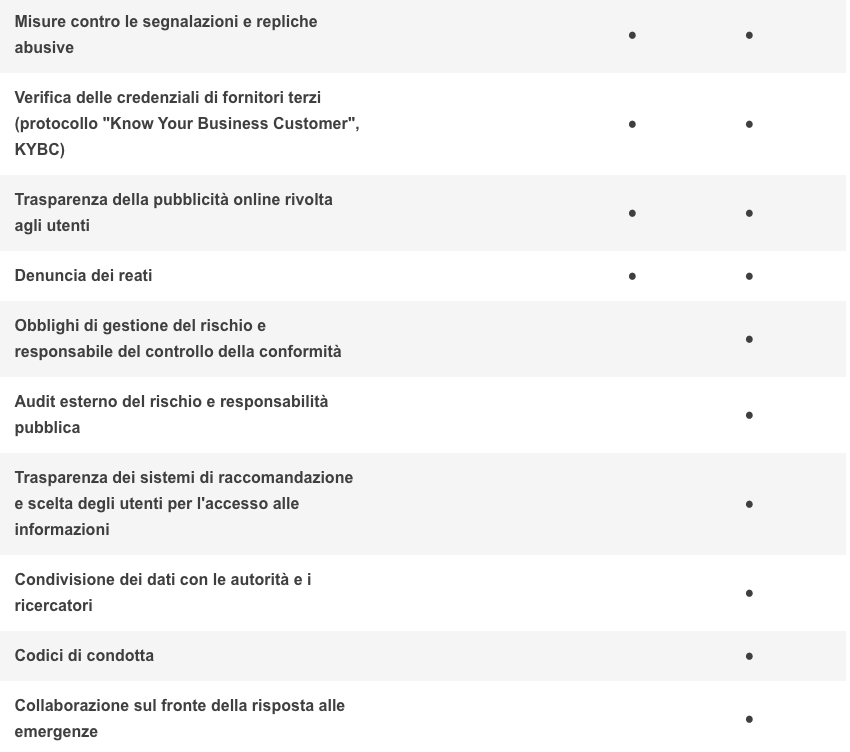

A seconda dei soggetti, gli obblighi – e le relative ammende – possono variare considerevolmente, come riassunto da questa tabella:

Rispetto ai contenuti trasmessi, comunicati, pubblicati, memorizzati sul web, esistono inoltre specifiche norme – previste in fonti normative vincolanti o atti di softlaw non vincolanti – a livello tanto internazionale quanto nazionale.

In primo luogo vi sono principi generali sovranazionali e costituzionali che devono trovare applicazione anche sul web, quali:

- le Convenzioni internazionali sui diritti umani (ex multis CEDAW, Convenzione di Istanbul contro la violenza sulle donne);

- la Carta dei diritti fondamentali dell’UE (ex multis 11 Libertà di espressione, art. 21 Divieto di discriminazione);

- la Convenzione europea dei diritti dell’Uomo (ex multis 10 Libertà di espressione e di informazione, art. 14 Divieto di discriminazione, art. 8 Diritto alla vita privata e familiare; art. 17 Divieto di abuso di diritto)

- la Costituzione Italiana (ex multis 2 Diritti inviolabili, art. 3 Principio di eguaglianza, art. 15 Libertà di corrispondenza, art. 21 Libertà di espressione, art. 24 diritto di difesa).

Circa la disinformazione, la Commissione Europea promosso una serie di iniziative di soft law non vincolanti, quali

- il Code of practice on disinformation (2018), siglato dalla Commissione europea e dai principali rappresentanti degli intermediari on line (Facebook, Google, Twitter, Mozilla), col quale le parti si impegnano a rispettare le norme del codice che rinviano a norme giuridiche vincolanti già esistenti (CEDU, Carta dei diritti fondamentali, Direttiva sull’e-commerce, norme sulla protezione dei dati personali);

- l’Action plan against disinformation, che definisce una serie di azioni strategiche per combattere la disinformazione valorizzando il ruolo della società civile.

Nell’ordinamento nazionale italiano, invece, non vi è una legge specifica per contrastare la disinformazione on line; tuttavia, possono trovare applicazione diverse fattispecie di reato (a seconda delle caratteristiche della fake news): come ad esempio art. 595 c.p. diffamazione, art. 658 c.p. procurato allarme, art. 501 distorsione del mercato, art. 640 c.p. truffa.

L’autorità indipendente AGCOM, inoltre, con la delibera 423/17, ha istituito un «tavolo tecnico per la garanzia del pluralismo e della correttezza dell’informazione sulle piattaforme digitali», volto a favorire l’autoregolamentazione delle piattaforme per contrastare la disinformazione. Infine, sono stati presentati due disegni di legge (BOSCHI ed altri, GAMBARO ed altri per prevenire e contrastare la manipolazione dell’informazione online e la pubblicazione di fake news), in attesa di essere calendarizzati e discussi.

Riguardo alla privacy e alla protezione dei dati, il GDPR Regolamento (UE) 2016/679 stabilisce principi fondamentali precisi in materia di raccolta e protezione dei dati personali (art. 5), mentre con la sentenza Google v Spain (2012) la Corte di giustizia dell’Unione Europea ha affermato il diritto all’oblio, e alla cancellazione di notizie dai risultati dei motori di ricerca.

In Italia esistono il Codice per la protezione dei dati personali (D.lgs n. 196 del 2003, adeguato alle norme del Regolamento europeo GDPR) e si segnala l’attività del Garante per la privacy: un’autorità amministrativa indipendente che controlla che i trattamenti di dati personali siano conformi alle norme europee e nazionali.

Circa i contenuti illeciti (hate speech, cyberbullismo, cyberstalking), la Commissione Europea ha adottato una serie di atti di soft-law per contrastare la diffusione di contenuti illegali sulla rete, partendo dal presupposto che «ciò che è illegale offline è illegale online».

Valgono in generale la Recommendation on measures to effectively tackle illegal content online, e le vincolanti Direttiva 2011/93/UE relativa alla lotta contro l’abuso e lo sfruttamento sessuale dei minori e la pornografia minorile, Direttiva (UE) 2017/541 sulla lotta contro il terrorismo, Hate speech on line e decisione quadro sulla lotta contro il razzismo e la xenofobia, che qualifica come reato l’istigazione pubblica alla violenza o all’odio in ragione della ‘razza’, della religione, dell’origine nazionale o etnica e si applica anche al web.

Tra le fonti non vincolanti, la più importante è il Code of conduct on countering illegal hate speech online, siglato dalla Commissione europea e da diverse piattaforme (Facebook, Microsoft, Twitter e YouTube Instagram, Google+, Snapchat, Dailymotion e Jeuxvideo.com) al fine di limitare la diffusione dei contenuti d’odio.

Sul Cyber-bullismo l’Italia si è dotata di una specifica legge nel 2017 (legge 71/2017), e in tema di Cyberharrasment e cyberstalking la giurisprudenza italiana ritiene applicabili a queste condotte il reato di atti persecutori (stalking) e di «revenge porn» di cui all’art. 612 bis Codice penale (legge 69/2019).

Sull’hate speech online, l’ordinamento nazionale non prevede tuttavia alcuna legge specifica. Online come offline possono comunque trovare applicazione i reati di Propaganda e istigazione a delinquere per motivi di discriminazione razziale etnica e religiosa (artt. 604 bis e ter Codice penale) – motivi ai quali il Disegno di legge Zan chiede di aggiungere quelli «fondati sul sesso, sul genere, sull’orien-tamento sessuale, sull’identità di genere e sulla disabilità» – e il 10 marzo è stata depositata alla Camera la proposta di legge Boldrini ed altri «Misure per la prevenzione e il contrasto della diffusione di manifestazioni d’odio mediante la rete internet» (2936), volta esplicitamente a contrastare la diffusione dell’odio on line.

La proposta di legge Boldrini ed altri (2936)

Redatta sul modello della Netzwerkdurchsetzungsgesetz (NetzDG), la legge sull’odio online in vigore in Germania dal 1 gennaio 2018, la proposta di legge prevede, fin dalle sue premesse, un approccio molto severo al contrasto al discorso d’odio prodotto e diffuso in rete, pur nel tentativo di coniugare regole chiare e libertà di espressione: «Bisogna impedire l’accesso alla rete internet da parte degli autori dei messaggi d’odio, per restituirla alla sua natura originaria di spazio di libertà e di condivisione. Perché questo sia possibile sono necessarie nuove regole… Non è vero che regolamentazione e internet sono incompatibili. È vero, invece, che l’assenza di regole non significa garanzia di un web libero, bensì prevalenza degli interessi dei più forti e perfino di abusi».

Da questa prospettiva, lo scopo della proposta è quello di «garantire la tutela della dignità e della libertà personale di chi naviga in rete e di fornire strumenti alle persone per fare sì che usino la rete in maniera responsabile», e di «responsabilizzare le piattaforme digitali affinché procedano alla tempestiva rimozione del discorso di odio prevedendo, al contempo, adeguate garanzie procedurali che consentano a tale meccanismo di enforcement privato di non limitare irragionevolmente la libertà di espressione degli utenti».

Ove non si dotino di tali meccanismi – spiega il testo – «le piattaforme incorreranno in sanzioni e sono tenute a produrre e a rendere pubbliche relazioni annuali sull’attività svolta a tali fini».

Oltre all’aspetto repressivo, viene menzionato un aspetto preventivo ed educativo («educazione civica digitale»), che tuttavia viene trattato, rapidamente, solo all’art. 9, nel quale si stabilisce che «le maggiori entrate derivanti dalle sanzioni amministrative pecuniarie irrogate per la violazione delle disposizioni della presente legge sono destinate alla realizzazione, nelle scuole di ogni ordine e grado, di specifici programmi di educazione digitale volti a far conoscere i pericoli e gli effetti derivanti dalle manifestazioni d’odio diffuse mediante la rete internet finalizzate alle discriminazioni e alla violenza, nonché a promuovere un uso consapevole e responsabile della stessa rete».

Pur lodevole nelle intenzioni, la proposta di legge non specifica chi dovrebbe disegnare e realizzare gli «specifici programmi di educazione digitale», e soprattutto si basa sull’assunto che l’unica disposizione in materia di prevenzione, relativa all’educazione digitale, possa essere attuata in seguito all’acquisizione di «maggiori entrate derivanti dalle sanzioni», quando risorse pubbliche adeguate e costanti – stanziate a prescindere dall’esito delle sanzioni amministrative – potrebbero invece essere destinate indipendentemente, e prima, dell’entrata in vigore della legge.

Altri punti del testo che restano da approfondire sono inoltre:

- la definizione di «gestori di siti internet» (art. 2), nella quale si dovrebbero includere fornitori di servizi e applicativi quali ad esempio WhatsApp, nei quali la circolazione di contenuti illeciti è cresciuta esponenzialmente negli ultimi dodici mesi; in generale, terminologia e definizioni nel testo andrebbero adeguate all’attuale configurazione della fornitura di servizi, che non contempla soltanto «siti» ma anche applicativi;

- la definizione di «contenuto illecito» (art. 4 comma 1), di fatto demandata agli articoli 604-bis e 604-ter del codice penale e alle modifiche proposte dal disegno di legge c.d. Zan: come noto, la possibilità di interpretare la norma vigente ha prodotto sentenze molto diverse, dagli esiti anche opposti;

- la definizione e la composizione dell’«organismo di autoregolamentazione composto da un numero di analisti esperti dotati di ampie e diverse competenze e di esperienza», a cui è preposto il cruciale e delicato compito di verificare l’illiceità del contenuto segnalato (art. 5 comma 4);

- i limiti temporali – 24 ore dalla ricezione della segnalazione – nei quali viene richiesta la rimozione o il blocco del contenuto «manifestatamente illecito» (art. 5 comma 5); tale limite, inizialmente previsto in Francia anche dalla legge Avia, è stato dichiarato incostituzionale dalla Corte costituzionale francese, visto che l’illeceità, in uno stato di diritto, dovrebbe essere suffragata dalla magistratura, la quale tuttavia non può pronunciarsi nell’arco temporale previsti dalla proposta di legge;

- l’entità delle sanzioni, adeguata alle grandi piattaforme ma penalizzante rispetto a fornitori di servizi e di applicativi di dimensioni ridotte, al punto da rischiare di favorire le grandi piattaforme a discapito della concorrenza (art. 7);

- la mancanza di riferimenti espliciti ad altri stakeholders oltre ai «gestori» di Internet, quali ad esempio soggetti istituzionali e utenti;

- la mancanza di soluzioni alternative alle sanzioni pecuniarie, quali provvedimenti di giustizia riparativa e non punitiva, che andrebbero oltretutto nella direzione di azioni preventive ed educative, di cui all’art. 9.